1.Qu'est-ce qu'un arbre de décision ?

Un arbre de décision est un schéma représentant les résultats possibles d’une série de choix interconnectés. Un arbre de décision permet à une personne ou une organisation d’évaluer différentes actions possibles en fonction de leur coût, leur probabilité et leurs bénéfices. Il peut être utilisé pour alimenter une discussion informelle ou pour générer un algorithme qui détermine le meilleur choix de façon mathématique. Un arbre de décision commence généralement par un nœud d’où découlent plusieurs résultats possibles. Chacun de ces résultats mène à d’autres nœuds, d’où émanent d’autres possibilités.

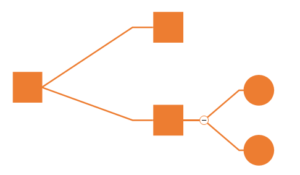

Il existe trois types de nœuds différents : des nœuds de hasard, des nœuds de décision et des nœuds terminaux. Un nœud de hasard, représenté par un cercle, montre les probabilités de certains résultats. Un nœud de décision, représenté par un carré, illustre une décision à prendre, et un nœud terminal le résultat final d’un chemin de décision. L’arbre de décision peut aussi être dessinés avec des symboles d’organigramme. Certaines personnes jugent que ce procédé génère des schémas plus simples à lire et à comprendre.

Cet outil d’aide à la décision ou d’exploration de données permet de représenter un ensemble de choix sous la forme graphique d’un arbre. C’est une des méthodes d’apprentissage supervisée les plus populaires pour les problèmes de classification de données. Concrètement, un arbre de décision modélise une hiérarchie de tests pour prédire un résultat. Il existe deux principaux types d’arbre de décision :

- L’ arbre de régression(Regression Tree) : permettent de prédire une quantité réelle, une valeur numérique (par exemple, le prix d’une maison ou la durée de séjour d’un patient dans un hôpital) ;

- L’arbre de classification (Classification Tree) : permettent de prédire à quelle classe la variable de sortie appartient (cela permet par exemple de répartir une population d’individus, comme des clients d’une entreprise en différents types de profils).

2.Avantages et inconvénients de l’arbre de décision :

L’arbres de décision est un des schémas qui tentent d’afficher la gamme des résultats possibles et les décisions ultérieures faites après une première décision. Par exemple, votre décision initiale pourrait être de savoir si d’aller au collège, et l’arbre de décision pourrait tenter de montrer combien de temps serait consacré à faire différentes activités et votre pouvoir d’achat en fonction de votre décision. Il y a plusieurs avantages notables et des inconvénients à l’aide d’arbres de décision. La popularité des arbres de décision se justifie par les raisons suivantes :

- Ils sont faciles à comprendre.

- Ils peuvent être utiles avec ou sans données concrètes, et les données quelles qu’elles soient nécessitent une préparation minimale.

- De nouvelles options peuvent être ajoutées aux arbres existants.

- Ils permettent de sélectionner l’option la plus appropriée parmi plusieurs.

- Il est facile de les associer à d’autres outils de prise de décision.

L’arbres de décision peut toutefois devenir extrêmement complexes. Dans ce cas, un diagramme d’influence, plus compact, peut représenter une bonne alternative. Les diagrammes d’influence se focalisent sur les décisions, données et objectifs critiques.

L’arbres de décision est instables et a tendance à overfiter. Être instable signifie qu’il suffit parfois d’ajouter ou de supprimer quelques exemples d’apprentissage, ou de modifier légèrement leurs propriétés, pour changer radicalement la structure de l’arbre. C’est embêtant lorsqu’on se base sur cette structure pour comprendre les relations entre les données. Par exemple, dans le cadre d’une analyse de causes primaires.

L’overfitting signifie qu’un arbre de décision a un peu trop tendance à tirer une généralité d’un cas particulier, d’un bruit ou d’une anomalie. De sorte que le modèle a du mal a correctement prédire de nouvelles valeurs après son apprentissage. Pour atténuer ce défaut, on peut utiliser des ensembles d’arbres, comme des forêts aléatoires.

3.Comment dessiner un arbre de décision ?

Pour dessiner un arbre de décision, il faut choisir d’abord un support. Puis le dessiner à main levée sur du papier ou sur un tableau blanc, ou utiliser un logiciel d’arbres de décision spécialisé. Dans tous les cas, voici les étapes à suivre :

- Commencer par la décision principale : Dessinez une petite boîte pour la représenter, puis dessinez une ligne partant de la boîte vers la droite pour chaque solution ou action possible. Étiquetez-les.

- Ajouter des nœuds de hasard et de décision : pour développer l‘arborescence comme suit :

- Si une autre décision est nécessaire, dessinez une autre boîte.

- Si le résultat est incertain, dessinez un cercle (les cercles représentent les nœuds de hasard).

- Si le problème est résolu, n’ajoutez rien (pour l’instant).

À partir de chaque nœud de décision, il faut dessiner les solutions possibles. À partir de chaque nœud de hasard, dessiner des lignes représentant les résultats possibles. S’il y a le besoin d’évaluer les options de façon numérique, ajouter la probabilité de chaque résultat et le coût de chaque action.

- Continuer à développer l’arbre jusqu’à ce que chaque ligne débouche sur un nœud terminal, indiquant qu’il n’y a plus de choix à faire ni de résultats possibles à prendre en considération. Ensuite, assigner une valeur à chaque résultat possible. Cela peut être un score abstrait ou une somme d’argent. Ajouter des triangles pour signaler les nœuds terminaux.

Une fois l’arbre de décision terminé, il possible de commencer à analyser la décision qui s’impose. L’arbre de décision est un outil qui permet également d’obtenir des résultats prévisionnels chiffrés selon les options retenues. Une aide précieuse pour alimenter la prise de décision.

Vous pouvez soit:

- Nous appeler directement,

- Nous envoyer un email,

- Ou demander à être recontacté à l'heure qui vous convient !

A PROPOS de NPM

« Le Cabinet New Performance Management est le fruit d’une longue expérience professionnelle au sein de grands groupes Internationaux, d’un profond attachement aux valeurs de travail en entreprise, d’amitié et de performance.

Nous conseillons et accompagnons les entreprises et les particuliers dans leur développement et mettons quotidiennement en œuvre des moyens humains et un savoir-faire à la hauteur des ambitions de nos clients.

Notre approche ciblée et qualitative nous permet de bénéficier d’une place de premier plan dans certains domaines comme l’ingénierie de la sécurité incendie, les études Environnementales, le conseil QSE, le Coaching, l’intelligence relationnelle au sein des équipes et la formation continue et certifiante.

New Performance Management, c’est avant tout un savoir-faire et un esprit d’équipe dont les enjeux sont la satisfaction de nos clients et l’épanouissement professionnel des équipes au Travail.

Notre valeur ajoutée : « un challenge au quotidien, des liens de confiance solides, un service sur mesure et l’utilisation des derniers outils du conseil pour des processus que nous souhaitons toujours plus performant. ».

consultants et formateurs expérimentés

Nos consultants et nos formateurs sont tous certifiés et sont des ingénieurs de Grandes Ecoles, avec plus de 16 d’expériences professionnelles dans des multinationales et des PME.

Ils nous ont fait Confiance

Prenez connaissance de vos obligations en sst

Pour Télécharger le décret sur les exigences réglementaires en Sécurité incendie au Maroc !